Эта статья поможет вам создать и изменить файл robots txt для wordpress с помощью плагина All in One SEO…

По умолчанию WordPress создаёт динамический файл роботс тхт, а модуль «инструмент» в плагине All in One SEO позволяет создавать, управлять этим файлом и менять значение по умолчанию.

Генерируя динамический robots.txt файл с помощью All in One SEO, как и WordPress вы создадите инструкции поисковикам о сайте. При этой настройке на сервере отсутствует статический файл robots.txt, а динамический хранится в базе данных WordPress и отображается в веб-браузере по адресу https://ваш сайт/robots.txt.

Чтобы начать работу в меню All in One SEO, нажмите на «Инструменты» и в редакторе включите ползунок «пользовательский robots.txt», при этом добавятся правила WordPress по умолчанию.

Если вы решите изменить правила, добавленные по умолчанию, то вам можно будет создать файл robots.txt в корневой папке WordPress с добавлением собственных правил.

Как это делается, мы рассмотрим далее в статье…

Пользовательские правила robots txt для wordpress

При создании пользовательского правила я придерживаюсь директивы User-agent от Яндекс. Например, боты Яндекс руководствуются правилами User-agent: Yandex и User-agent: * и запись User-agent: Yandex при этом в приоритете перед записью User-agent: *. Можно понимать так, если даны указания роботам Яндекс, то будет использоваться директива User-agent: Yandex, а User-agent: * будет игнорироваться.

Например, на моих сайтах роботс.тхт настроен так (см. ниже), а вы можете настроить по своим предпочтениям.

Правила роботс.тхт на моих сайтах

User-agent: * # Разрешается всем роботам сканировать сайт

Disallow: /wp-admin/ # Закрыли админку

Allow: /wp-admin/admin-ajax.php # Открыли аякс

Disallow: /cgi-bin # Стандартная папка на хостинге

Disallow: /? # Все параметры запроса на главной странице

Disallow: *?s= # Страницы поиска

Disallow: /author/ # Архив автора

Disallow: */embed # Все встраивания

Disallow: */xmlrpc.php # Файл WordPress API

Disallow: *utm*= # Ссылки с utm-метками

Disallow: *openstat= # Ссылки с метками openstat

Disallow: /type/ # Дубли страниц от установленной темы

Disallow: /ads.txt # Файл txt защита рекламодателей от мошенников

Sitemap: https://Здесь ваш домен сайта/sitemap.xml

Если нет никаких записей, то считается, что роботам нет ограничений для этого сайта…

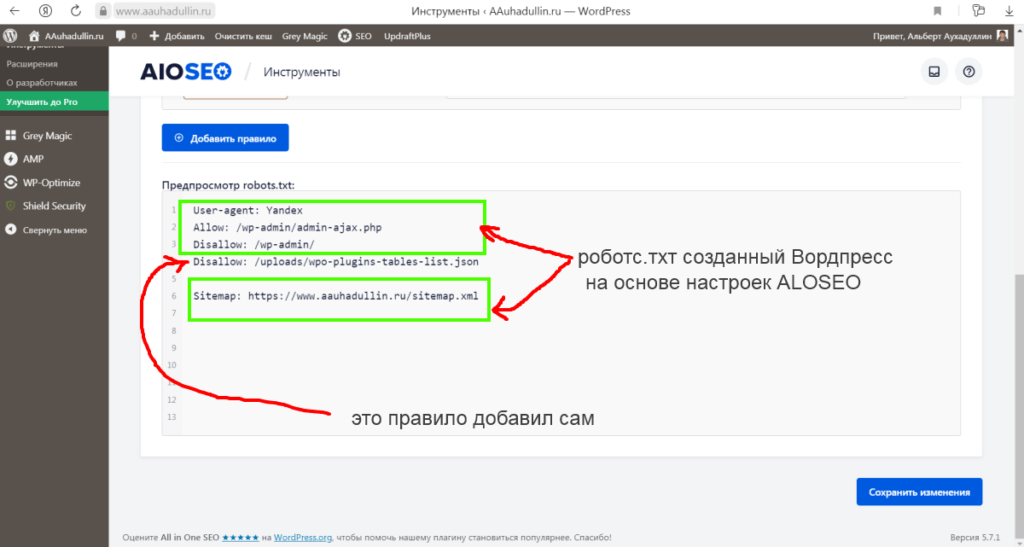

Итак, при нажатии кнопки «Добавить правило» у вас выйдет примерно такой роботс по умолчанию от Вордпресс (см. фото).

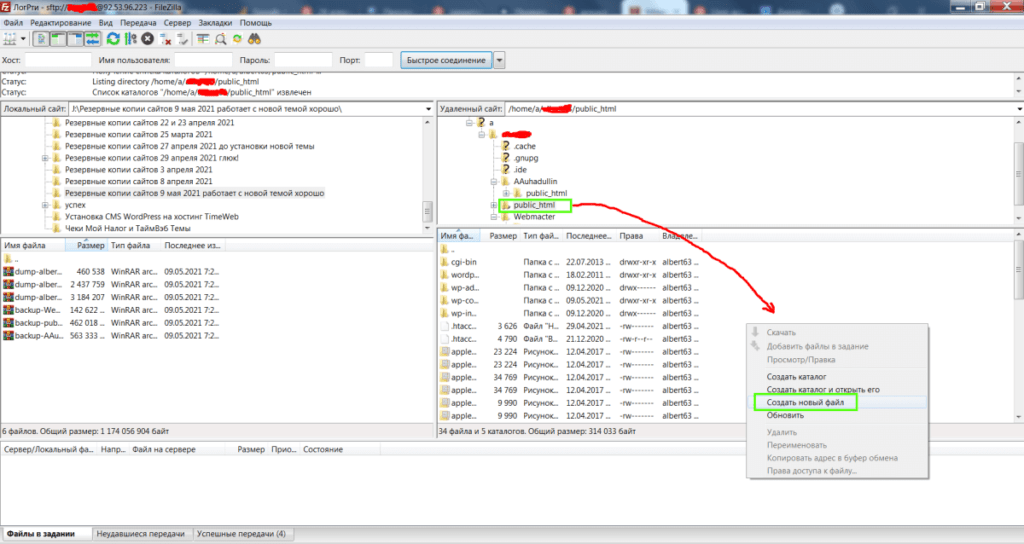

Как говорилось выше в статье мы создадим свой статический файл robots.txt и сделаем его динамическим с помощью SEO плагина и бесплатного FTP-клиента FileZilla. Скачайте и установите на компьютер, кстати, отличная программа для работы с сайтами.

- Через программу FTP-клиент открываем корневую папку на сервере своего хостинга.

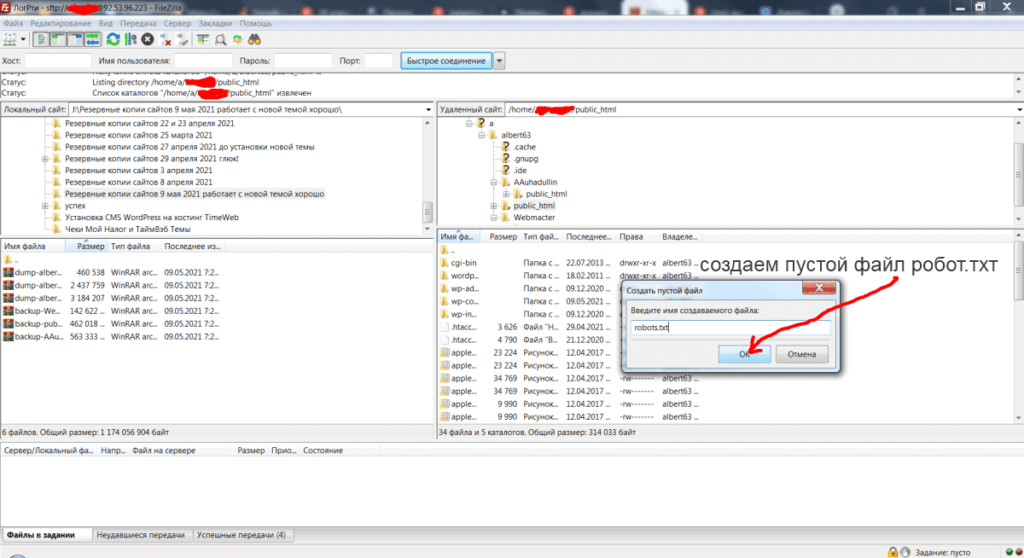

- Далее создается новый пустой файл с названием robots.txt.

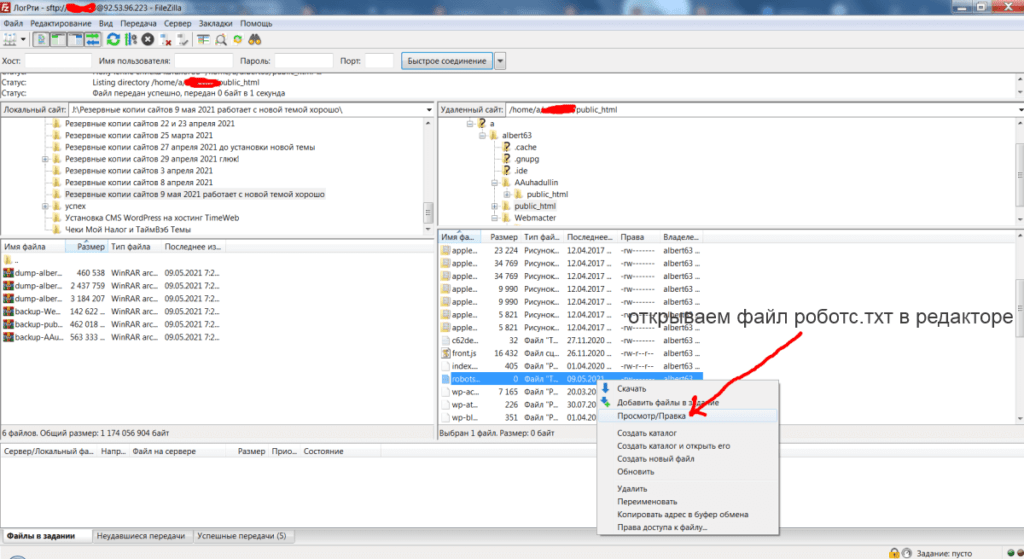

Выделяете созданный файл мышкой, нажимаете на Просмотр/Правка и открываете файл редактором Notepad++. Здесь прописываете директивы, которые должны работать, как часы без ошибок на вашем сайте.

- Затем прописываете свой роботс.тхт и нажимаете сохранить.

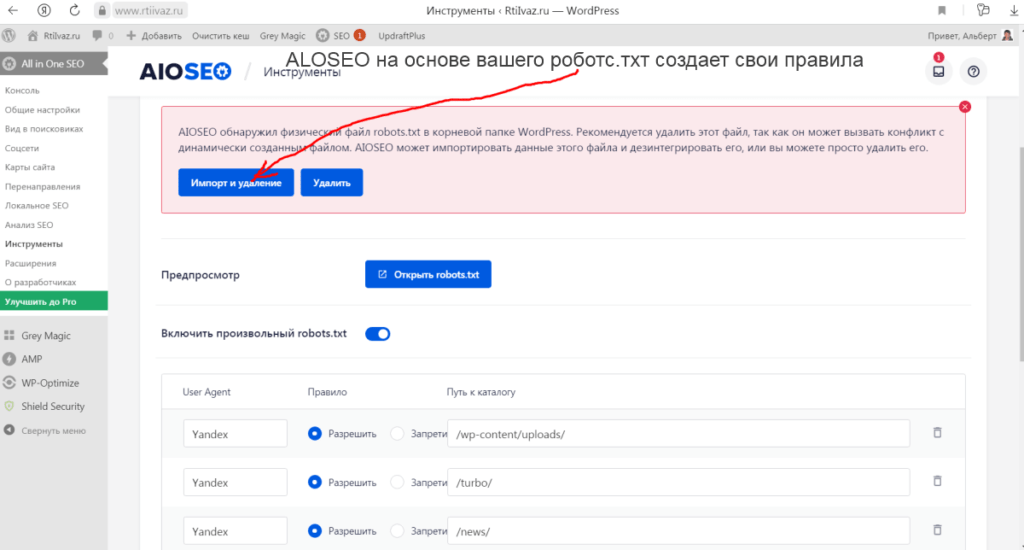

Далее нужно зайти в админку Вордпресс и в плагине Aloseo открыть модуль Инструменты и, тут нажать кнопку Импорт и Удаление.

После этого создается динамический роботс.тхт, который можно здесь редактировать, удалять и добавлять другие правела.

В инструментах ВебМастер.Яндекс нужно проверить результаты анализа robots.txt…

Вот и всё, остаётся ждать, когда изменения роботс.тхт вступят в силу, на это может уйти 2-3 недели или больше и поэтому отнеситесь к его составлению серьёзно. Через пару дней после настройки плагина в All in One SEO проверьте соответствие кодов ответа в панели ВебМастер Яндекс → Статистика обход → Все страницы.

Меня больше интересует, как это фуфло отключить. Я привык обходиться robots.txt в файлике.

Выключается в настройках плагина: Инструменты — Редактор robots.txt — Включить произвольный robots.txt. У меня хорошо работает robots.txt в плагине AIOSEO и не создает нагрузки на сайт. Было предупреждение Возможно, файлу robots.txt нет правила перезаписи. Возможно, ваш сервер работает на Apache и поэтому для исправления ошибки нужно проверить правильность формирования .htaccess на wordpress.org. Прописал в .htaccess перенаправление на robots.txt (см. ниже) и сейчас работает:

SetEnvIf X-HTTPS 1 HTTPS

RewriteEngine On

RewriteBase /

RewriteCond %{HTTP:X-HTTPS} !1

RewriteCond %{REQUEST_URI} !robots.txt

RewriteRule ^(.*)$ Ваш Сайт$1 [R=301,L]

Как решить проблему? Есть статический файл {https://site-domen.name/robots.txt}. После активации плагина AIOSEO , плагин предлагает удалить статический файл robots.txt и импортировать его содержимое. После того как я нажимаю «импортировать и удалить» файл рототс не находится по пути {https://site-domen.name/robots.txt} и поисковые машины (яндекс к примеру) сообщают, что не могут найти этот файл. Что я делаю не так? Как исправить? Так как если не удалять статический файл, то AIOSEO не работает корректно — в поисковой выдаче все в кашу, как-будто плагин не работает.

Анатолий, зайдите на сервер через FTP и посмотрите права доступа статическому файлу роботс.тхт, должен быть 600 и там же можно удалить этот файл robots.txt. Как откроете права доступа, ещё раз попробуйте удалить статический файл robots.txt и импортировать его содержимое. Затем проверьте динамический файл созданный, плагином ALL in One SEO. Возможно, какой-то плагин не даёт делать изменения в файле роботс.тхт, нужно попробовать отключить все плагины оставив только ALL in One SEO и повторить, нажав на кнопку «импортировать и удалить».